04-6 Gradient Boosting Machine (GBM)

개요

내용정리

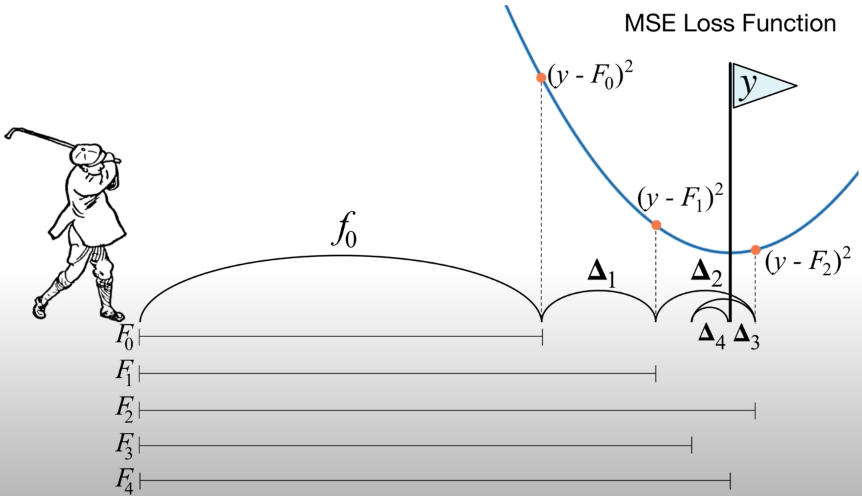

- Gradient Boosting = Gradient Descent + Boosting

- 순차적 순서로 앙상블 하는 기법

- 각 스테이지에서 앞선 weak learning의 단점을 보완하기 위한 weak learner가 등장함

- Ada Boost에서는 단점이 조금 더 높은 가중치로 반영되는 반면 Gradient Boosting에서는 단점이 gradient에서 반영됨

- GBM은 3가지 Task 가 모두 수행가능함

- Regression, Classification, Ranking

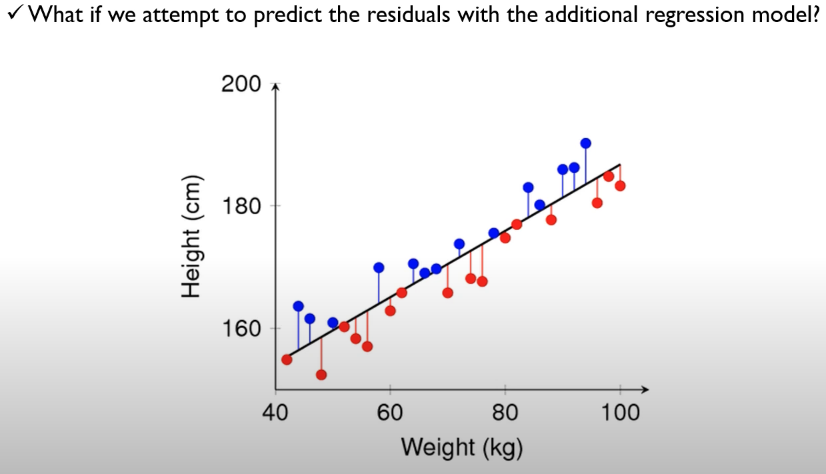

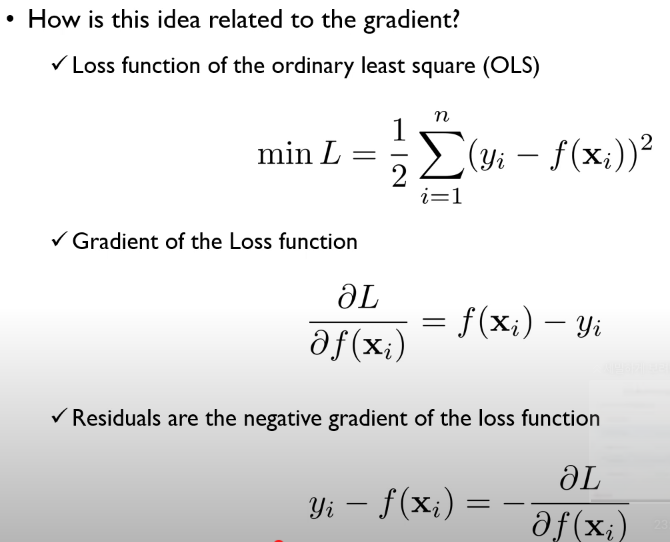

- Motivation (for regression problem)

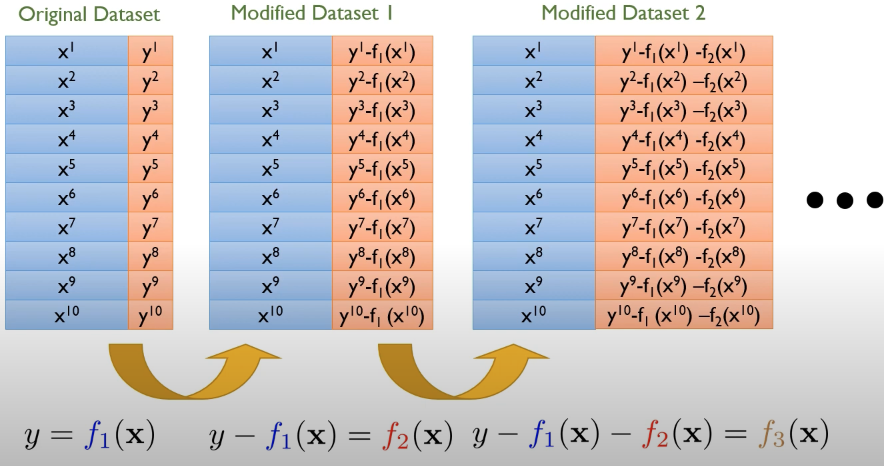

- Main Idea

- GBM 동작 예시

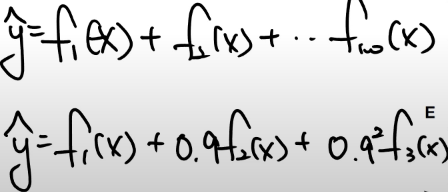

- 결과적으로 linear regression 아이디어와 매우 유사함

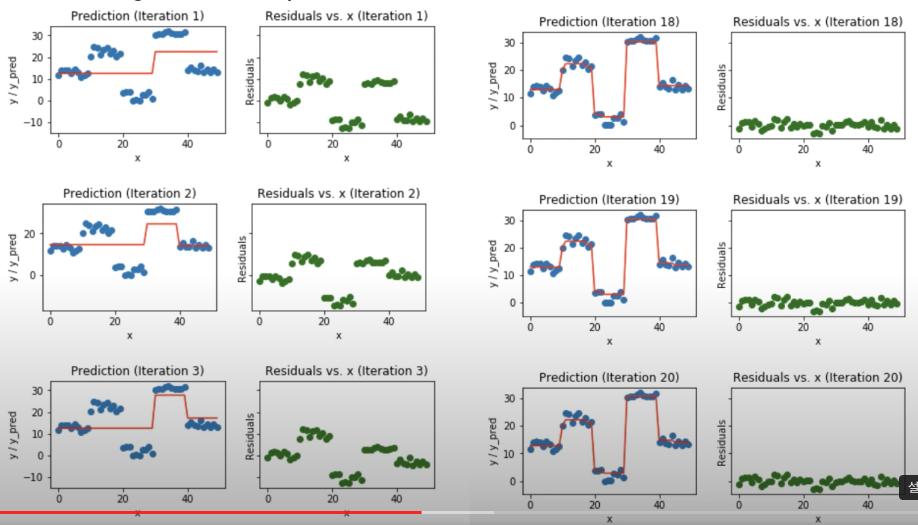

- 동작 예시

- Iteration을 반복하며 에러를 이는 방향으로 Decision Boundary가 형성됨

-

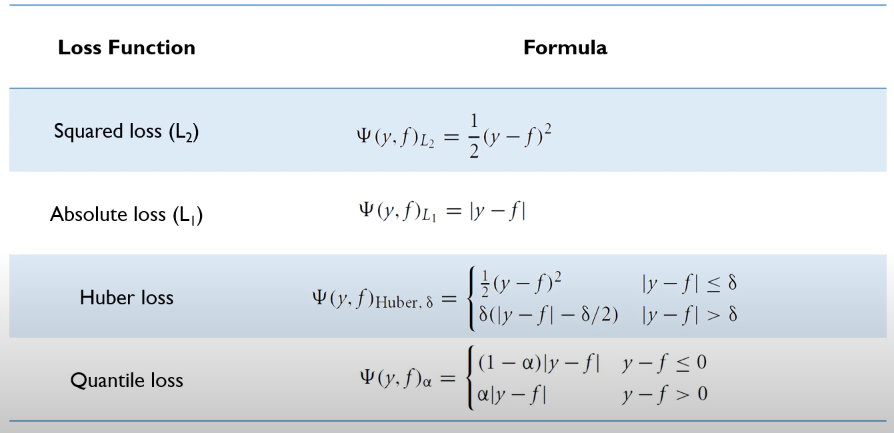

Regression용 loss

-

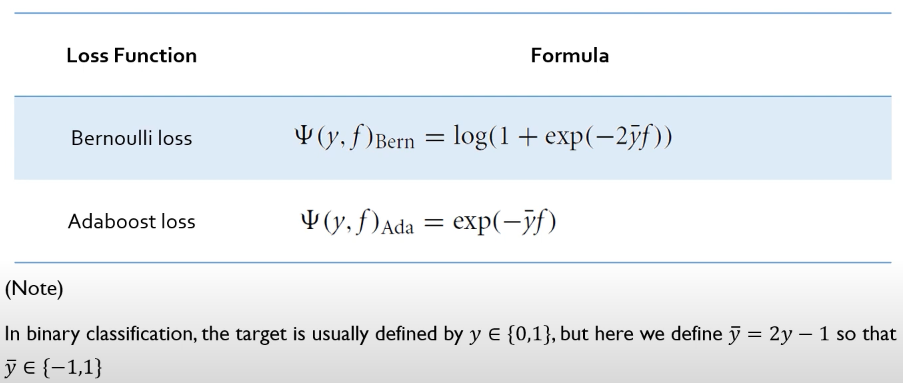

Classification용 loss

-

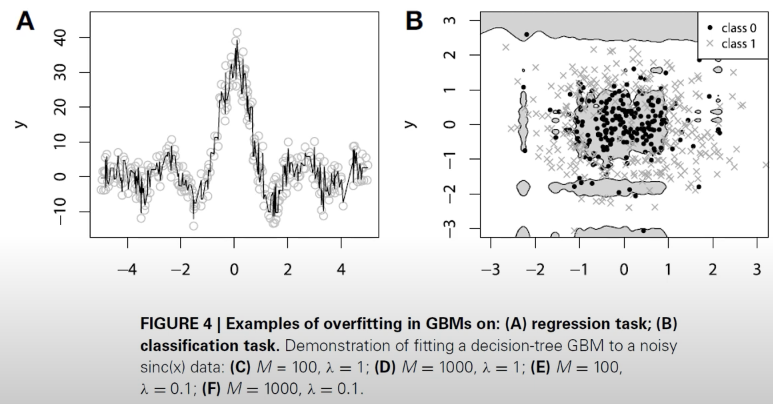

GBM이 가진 큰 Risk 중 하나는 Overfitting

-

모델 갯수가 많을수록 overfit 되기 쉬움

-

-

Regularization

-

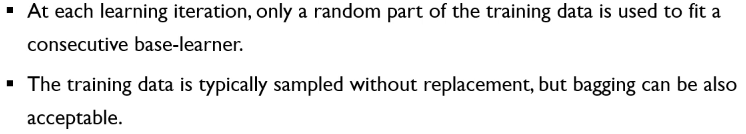

subsampling

-

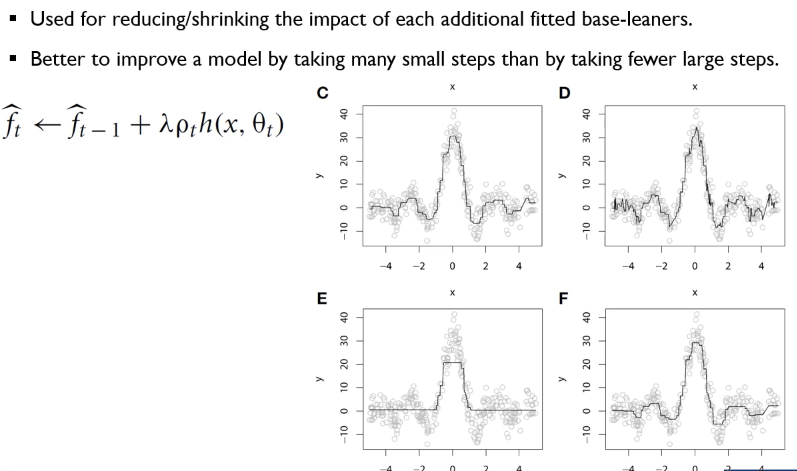

Shrinkage

- Shrinkage 방법은 의도적으로 점점 후속 모델들의 가중치를 떨어트림

-

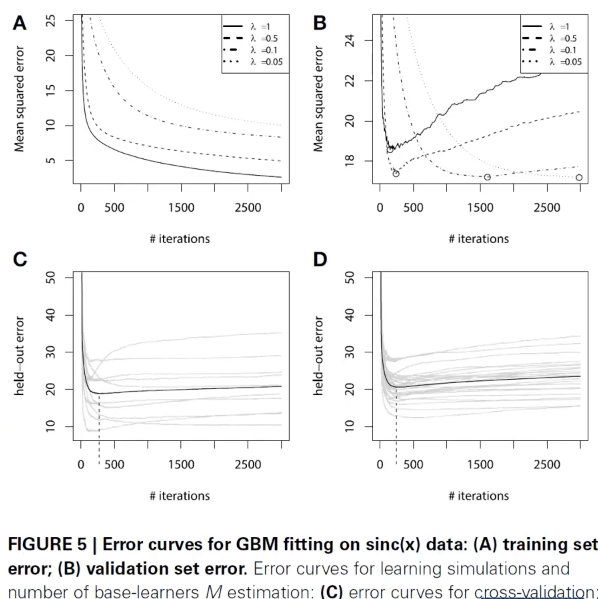

Early Stopping

- validation error을 통해 일정 수준 error가 증가할것 같으면 일찍 끝내 버림

-

-

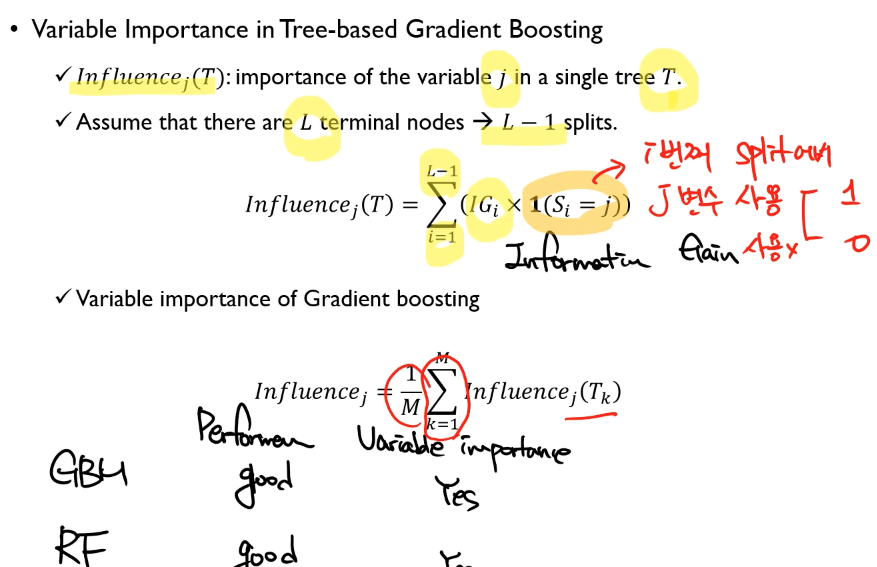

Random Forest vs GBM importance 계산

- RF 대비 중요도 계산이 단순하다.

- 변수 j의 단일 트리 T에대한 중요도 계산 방법

- L개의 종단 노드가 있다면 L-1개의 스필릿이 존재하니 그 갯수만큼 순회하면서 J변수 사용여부로 0/1로 계산

- j에 대한 전체 영향도 계산

- M개의 트리에서의 각 영향도를 다 더한뒤 평균냄